Введение

В чем же успех ГРИД? В самом начале зарождения идеи распределенных вычислений и мультикомпьютинга ГРИД задумывали как подобие электрической сети: каждый человек может использовать сеть благодаря универсальности технологий и заложенных стандартов, развитой инфраструктуре, абсолютно не заботясь о том, от какой электростанции, по какому кабелю к розетке подается напряжение.

Первый и уверенный шаг ГРИД – реализация программы Национального научного фонда США (NSF), 1985-1995 гг. Результат – создание развитой коммуникационной инфраструктуры и нескольких суперкомпьютерных центров для поддержки академических работ и исследований. Затем в 1998 году был создан инструментальный пакет Globus Toolkit, который является технологической базой создания ГРИД-инфраструктуры (стандарт de facto). В 1999-м году сформировалось (и активно действует) международное научное ГРИД-сообщество Global Grid Forum (GGF). GGF и IBM в 2000-м году представили новую системную разработку – Open Grid Service Architecture (OGSA). В 2002-м создано объединение Enterprise Grid Alliance (EGA). А в 2006-м году GGF и EGA объявили о слиянии и образовании Open Grid Forum (OGF). И все это – великие события, между которыми осуществлялись огромные работы по становлению того ГРИД, который существует сегодня.

Организация ГРИД

В основе ГРИД лежат вычислительные мощности компьютеров, хранилища данных, объединенных в единую сеть и образующих ГРИД-узел (Рис. 1). Набор ГРИД-узлов представляет собой ГРИД-сеть (ГРИД-сайт), а набор ГРИД-сетей в свою очередь образует ГРИД-систему. Возможны объединения ГРИД-систем внутри страны, между странами. Таковые объединения возникают, как правило, на основе ГРИД-инициатив. ГРИД-проекты включают в себя большое количество географически распределенных ГРИД-систем на международном уровне. Помимо этого существует понятие «виртуальное ГРИД-сообщество», которое представляет собой создаваемую на определенное время виртуальную организацию (ВО) под актуальную задачу и с использованием ресурсов набора ГРИД-систем. В роли связки между ГРИД-системами и ВО выступают координационные центры (координационная организация, КО), управляющие выделением/распределением ресурсов.

Таким образом, получается следующая схема. Для выполнения конкретного объема вычислений виртуальное сообщество обращается в координационную организацию. КО работает с провайдером ПО, провайдером аппаратных ресурсов и финансовым экспертным центром. Под задачу выделяются ресурсы ГРИД. Во время выполнения вычислений возможно осуществление мониторинга хода этих вычислений, получение промежуточных и конечного результатов через средства визуализации. При этом факт гетерогенности самих вычислительных ресурсов «скрыт» от пользователей ГРИД за счет неотъемлемого применения специализированного ПО – grid middleware.

Если часто возникают задачи, требующие больших вычислительных ресурсов и хранилищ данных (а так и есть), то по ГРИД-инициативе возможно объединение нескольких сетей/систем.

Чтобы перейти на уровень ГРИД-метакомпьютинга, должны работать ГРИД-проекты. По просьбе ВО или на основе ГРИД-инициатив объединения ГРИД-систем существуют несколько лет.

ГРИД-системы

США. TeraGrid

США. TeraGrid

В США GRID-систему можно охарактеризовать как полноценную отрасль экономики. Внутри GRID обеспечено множество рабочих мест. Каждый человек получает здесь хороший социальный пакет и пенсионное обеспечение. Каждый человек, который внесет значимый вклад в GRID, может быть удостоен награды до нескольких миллионов долларов. Помимо всего этого здесь наблюдается средоточие всех инновационных технологий.

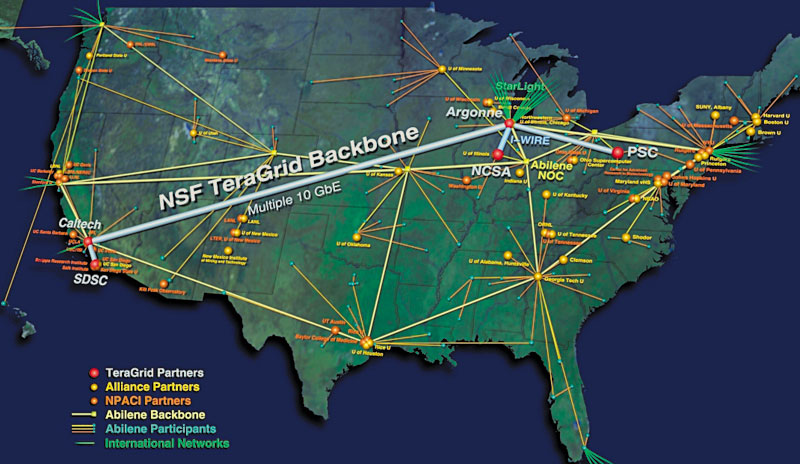

Чтобы понять, что такое GRID в США, нужно взглянуть на карту, раскрывающую географию и масштабы системы мультикомпьютинга (см. Рис.2).

Девиз TeraGrid: использовать только самое новое программное и аппаратное обеспечение, строить самые быстрые сети, осуществлять новые практики на системе, разрабатывать и совершенствовать политики и стандарты. TeraGrid включает в себя множество независимых (внешних) ГРИД-сайтов: NCSA, SDSC, ANL, Caltech, PSC (под ETF).

Обеспечение мультикомпьютинга возложено на оборудование Intel/Linux Clusters, Alpha SMP clusters, POWER4 cluster и т.д. Сайты NSCA, SDSC, ANL оснащены системами: узлы IBM Itanium Node, объединенных в сеть Myrinet; компьютерный центр TeraScale (6 Teraflops, HP/Compaq Tru64 Unix 3000 Alpha EV68 processors (750x4p, 4GB RAM/node (3TB total), Dual-rail Quadrics Interconnect); компьютерный центр HP GS1280 «Marvel» Systems (0,4 teraflops HP/Compaq Tru64 Unix 128 Alpha EV7 processors, 512Gm Shared memory, Quadrics connectivity to LeMieux).

Используется множество мощных программных пакетов, различных по своему назначению: непосредственно grid-middleware (проекта Globus, ПО «data management» и т.п.), ПО тестирования (ENZO, PPM), функциональное ПО (Cactus, ENZO, EOL, Gadu, LSMS, MCell, MM5, Montage, NAMD, NekTar, PPM, Quake).

Таблица 1. Организация доступа к данным

Очень большое внимание уделяется доступности ресурсов системы (Таблица 1).

Европейская ГРИД

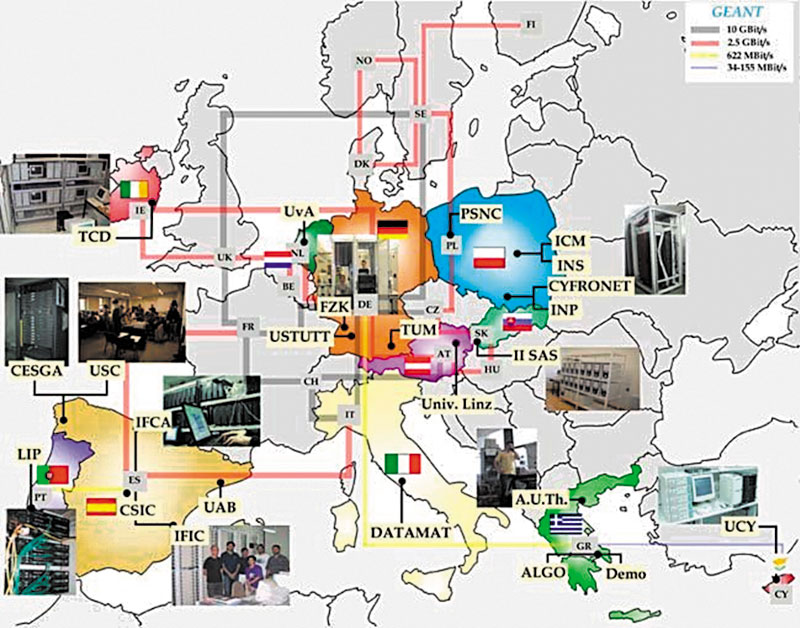

Соединение европейских ГРИД в единую систему осуществлено в рамках сетевого проекта GEANT (Рис. 3).

Рис. 3. Сеть европейских ГРИД-систем

«CoreGRID» (http://www.coregrid.net)

![]() В рамках проекта «CoreGRID» ведутся работы по исследованию и разработке ГРИД-технологий (передача данных, программное обеспечение и приложения и т.д.). Основной упор делается на применение перспективных технологий в ГРИД: управление знаниями (knowledge & data management), построение новых программных моделей и архитектур и т.д. Проект использует собственную инфраструктуру, построенную путем объединения шести европейских институтов.

В рамках проекта «CoreGRID» ведутся работы по исследованию и разработке ГРИД-технологий (передача данных, программное обеспечение и приложения и т.д.). Основной упор делается на применение перспективных технологий в ГРИД: управление знаниями (knowledge & data management), построение новых программных моделей и архитектур и т.д. Проект использует собственную инфраструктуру, построенную путем объединения шести европейских институтов.

«BEinGRID» (http://www.beingrid.com)

«BEinGRID» (http://www.beingrid.com)

Как и «CoreGRID», данный проект напрален на всестороннее изучение и практические исследования применения ГРИД для бизнеса. Проект отличается тесным взаимодействием с существующими общеевропейскими ГРИД-проектами.

![]() BRIEN (http://www.eu-brein.com)

BRIEN (http://www.eu-brein.com)

Основное назначение проекта «BREIN» – разработка методов и технологий коммерческого применения ГРИД-технологий. Для достижения этой цели ведутся исследования по переносу различных бизнес-моделей в распределенную среду.

Юго-восточная Европейская ГРИД (SEE-GRID http://www.see-grid.org/)

Юго-восточная Европейская ГРИД (SEE-GRID http://www.see-grid.org/)

Проект объединяет 12 стран, его основной целью является развитие инфраструктуры в регионе стран-участниц. Он активно поддерживается правительствами этих государств.

Великобритания

Великобритания

Проект EDG (European Data Grid). Официальное имя проекта – DataGrid. Цель: разработка ПО промежуточного уровня, основанного на Globus и пакете CONDOR, и развертывание полигонов для специфических научных приложений (ФВЭ, наблюдение Земли, биоинформатика).

UK National Grid Service (NGS)

UK National Grid Service (NGS)

NGS учреждена в апреле 2004 г. советом центральной лаборатории CCLRC (Council for the Central Laboratories of the Research Councils), сейчас известной как STFC (Science and Technology Facilities Council). Работает в рамках EDG.

Доступ к вычислительным ресурсам осуществляется через брокера NGS и прикладной портал NGS. Выполнение и поддержку задач осуществляет брокер ресурсов NGS (Resource Broker), а в качестве ПО middleware используется gLite 3.0

Помимо решения задач в рамках EDG, принимаются задачи от проекта EGEE.

Германия

http://www.d-grid.de

В Германии ГРИД организована следующим образом. В марте 2004 г. был создан проект D-GRID, который сегодня является объединением большого количества существующих внутри страны ГРИД-систем. D-Grid образован по D-инициативе Федерального министерства науки и образования. В состав данного проекта входят следующие системы:

В Германии ГРИД организована следующим образом. В марте 2004 г. был создан проект D-GRID, который сегодня является объединением большого количества существующих внутри страны ГРИД-систем. D-Grid образован по D-инициативе Федерального министерства науки и образования. В состав данного проекта входят следующие системы:

ГРИД - сети.

AeroGrid – ГРИД-система, работающая в интересах авиационной промышленности, авиационного инжиниринга.

AeroGrid – ГРИД-система, работающая в интересах авиационной промышленности, авиационного инжиниринга. AstroGrid-D – работа в области астрономии, астрофизики.

AstroGrid-D – работа в области астрономии, астрофизики. BIS-Grid – работает на развитие бизнеса, предоставляет ресурсы под интересы ERP, CRM.

BIS-Grid – работает на развитие бизнеса, предоставляет ресурсы под интересы ERP, CRM. F&L-Grid – сеть, предоставляющая сервисы для науки и образования.

F&L-Grid – сеть, предоставляющая сервисы для науки и образования. FinGrid – решение задач финансового характера, тесное взаимодействие с банковскими структурами.

FinGrid – решение задач финансового характера, тесное взаимодействие с банковскими структурами. GDI-Grid – задачи по сведению ГИС-технологий и ГРИД, разрешение парадигмы «OpenGIS Reference Model (ORM) and the architecture of the OGC Web Services (OWS)».

GDI-Grid – задачи по сведению ГИС-технологий и ГРИД, разрешение парадигмы «OpenGIS Reference Model (ORM) and the architecture of the OGC Web Services (OWS)». HEPCG – возложено решение задач в области физики высоких энергий.

HEPCG – возложено решение задач в области физики высоких энергий. In-Grid – тестирование и разработка приложений в интересах ГРИД-проектов.

In-Grid – тестирование и разработка приложений в интересах ГРИД-проектов. MediGRID – исследования в области биомедицины.

MediGRID – исследования в области биомедицины. PartnerGrid – е-сотрудничество для индустрии. Работа с CAD-проектами.

PartnerGrid – е-сотрудничество для индустрии. Работа с CAD-проектами. ProGRID – «библиотека проектов» – накопление информации об успешно реализованных проектах, предоставление и демонстрация необходимого материала по заказу.

ProGRID – «библиотека проектов» – накопление информации об успешно реализованных проектах, предоставление и демонстрация необходимого материала по заказу. SuGI Grid – на основе базы знаний по ГРИД решение вопросов о расширении возможностей системы, дальнейшего развития, а также постановка экспериментов в данных целях.

SuGI Grid – на основе базы знаний по ГРИД решение вопросов о расширении возможностей системы, дальнейшего развития, а также постановка экспериментов в данных целях. TextGrid – один из первых в Европе проектов по поиску, обработке (синтаксический и семантический разбор, классификация и т.д.), подготовке к изданию текстовой информации.

TextGrid – один из первых в Европе проектов по поиску, обработке (синтаксический и семантический разбор, классификация и т.д.), подготовке к изданию текстовой информации. WISENT – решение задач в области метеорологии.

WISENT – решение задач в области метеорологии. StemNet – проект предназначенный для взаимодействия с миром фармацефтики, биомедицины, организация единого пространства, единой базы.

StemNet – проект предназначенный для взаимодействия с миром фармацефтики, биомедицины, организация единого пространства, единой базы.Сервисные подразделения:

BauVOGrid – работа с ВО, сведение ВО с целевыми ГРИД-системами, организация выделения ресурсов.

BauVOGrid – работа с ВО, сведение ВО с целевыми ГРИД-системами, организация выделения ресурсов. Biz2Grid – основное назначение контроль и управление инфраструктурой систем внутри D-Grid проекта с целью организации наиболее рационального использования информационных и вычислительных ресурсов.

Biz2Grid – основное назначение контроль и управление инфраструктурой систем внутри D-Grid проекта с целью организации наиболее рационального использования информационных и вычислительных ресурсов. C3Grid – решение вопроса прозрачности работы в гетерогенной среде вычислительных ресурсов, обеспечение наиболее простого доступа к целевым элементам системы, максимальная открытость для ВО.

C3Grid – решение вопроса прозрачности работы в гетерогенной среде вычислительных ресурсов, обеспечение наиболее простого доступа к целевым элементам системы, максимальная открытость для ВО. DGI – данной системе назначена роль координатора внутри D-Grid проекта.

DGI – данной системе назначена роль координатора внутри D-Grid проекта. D-MON – решение вопросов мониторинга текущих задач и свободных ресурсов.

D-MON – решение вопросов мониторинга текущих задач и свободных ресурсов. IVOM – координация и менеджмент ВО.

IVOM – координация и менеджмент ВО. Im Wissensnetz – девиз «наука доступна каждому», организация некоего единого поля высокотехнологичных наук и доступа к нему с индивидуального рабочего места.

Im Wissensnetz – девиз «наука доступна каждому», организация некоего единого поля высокотехнологичных наук и доступа к нему с индивидуального рабочего места. eSciDoc – обеспечение эффективного информационного обмена в интересах ГРИД, организация конференций, семинаров, обеспечение публикаций.

eSciDoc – обеспечение эффективного информационного обмена в интересах ГРИД, организация конференций, семинаров, обеспечение публикаций. HyperImage – решение вопросов имиджа проекта, устранение конфликтных ситуаций.

HyperImage – решение вопросов имиджа проекта, устранение конфликтных ситуаций.

Дополнительно работают еще две организации: Ontoverse – ведение онтологии D-GRID; WIKINGER – взаимодействие с wiki-сервером.

Таким образом, представленный в Герамнии ГРИД-проект является полноценной отраслью, способной выполнять практически любые задачи, которые ставят перед ней промышленность, наука и образование, бизнес и экономика, а также задачи в рамках евро- и мирового ГРИД-проектов.

Польша

![]() CrossGrid - инициатива CrossGrid, как и все европейские инициативы, работает в рамках EGEE/LCG, EDG.

CrossGrid - инициатива CrossGrid, как и все европейские инициативы, работает в рамках EGEE/LCG, EDG.

CrossGrid включает три основных системы: Cyfronet, ICM, IPJ.

Cyfronet отводится роль координатора проектов, управление командой разработчиков и взаимодействия с партнерами по ГРИД.

Cyfronet отводится роль координатора проектов, управление командой разработчиков и взаимодействия с партнерами по ГРИД.

Кластер Cyfronet: 80 Intel CPU (2.4 – 2.6 GHz), 4 TB массив; UniTree ленточная библиотека (10 TB) ; сеть на базе HP ProCurve Switch 40 ports 100Mb/s and 1 port 1Gb/s (uplink). Часть кластерной мощности выделяется для проведения испытательных работ (CrossGrid testbeds), часть зарезервирована для EGEE, часть ресурсов используется под LHC Computing Grid.

ICM (Interdisciplinary Centre for Mathematical and Computational Modelling, Univerity of Warsaw).

ICM (Interdisciplinary Centre for Mathematical and Computational Modelling, Univerity of Warsaw).

Перед ICM стоят следующие задачи:

- WP1 – разработка прикладного ПО под задачи «Прогнозирование погодных условий», «Загрязнение окружающей среды»;

- WP3 – предоставление новых сервисов, обеспечение мониторинга;

- WP4 – проведение испытательных и тестовых работ.

Кластер ICM: объединения по 4 узла на базе PIII, 1 GHz, 1GB RAM, 1 CE и 1 SE (0.8 TB хранилище), 1 PBS-сервер.

IPJ (The A. Soltan Institute for Nuclear Studies, Warsaw)

IPJ (The A. Soltan Institute for Nuclear Studies, Warsaw)

Задачи, стоящие перед IPJ:

- WP1 – разработка прикладного ПО под задачу «Распределенный анализ данных в области физики высоких энергий»;

- WP4 – проведение испытательных и тестовых работ.

Кластер IPJ: сдвоенные рабочие узлы на базе PIII, 1 GHz, 1GB RAM, 1 CE and 1 SE (0.8 TB хранилище), 1 PBS-сервер.

Бельгия

BeGrid. http://www.begrid.be

BeGrid. http://www.begrid.be

BeGrid-инициатива создана в 2003 г. в исследовательских интересах Бельгии и была включена в ГРИД-карту Европы. Сегодня в BeGRID представлена вычислительная мощность из 650 CPU, в качестве middleware используется стандарт EGEE – ПО qLite 3.

Вычислительные мощности распределены в следующих подразделениях: университет в Намуре, Католический университет Левена, университет в Антверпене, Институт фон Кармена, лаборатория физики Солид-стэйт и др. Помимо этого существует несколько независимых узлов, входящих в ГРИД-структуру. И сегодня iSCF (Interuniversity Scientific Computing Facility) имеет следующие ресурсы: 80 Sun Fire V60x, 19 Sun Fire V20z and 2 Sun Fire V880: кластер из 101-го узла с 214-ю микропроцессорами, 1103.4 GFlops, 480 GB память, хранилище 5.7 TB. Используются также три основных архитектуры: UltraSPARC® III @ 900 MHz, Intel® Xeon™ @ 2.8 GHz и AMD Opteron™ 250 @ 2.4 GHz. Базовые ОС: SunOS и GNU/Linux. Объединение узлов и кластеров осуществлено на основе гигабитной сети ethernet.

Италия

«IGI» (The Italian Grid Infrastructure: http://grid-it.cnaf.infn.it)

«IGI» (The Italian Grid Infrastructure: http://grid-it.cnaf.infn.it)

Проект «IGI» был открыт в 2006 г. как продолжение другого национального ГРИД-проекта «GRID.IT» (http://www.grid.it). Оба проекта направлены на развитие общей европейской доктрины «E-sciencE» и являются частью общей инфраструктуры проекта EGEE (http://eu-egee.org). Участниками проекта являются крупнейшие итальянские университеты, исследовательские институты. Сетевая инфраструктура проекта наложена на итальянскую национальную сеть для исследований и образования.

Целью проекта является развитие технологий глобального использования вычислительных ресурсов для различных сфер науки: физики, астрофизики, биологии, медицины, геофизики, экономики и финансов. Большое внимание в проекте уделяется исследованиям и разработке средств для применения технологии «управления знаниями» (knowledge management). Использование такой технологии позволит работать с гигантскими объемами распределенных данных на принципиально новом уровне.

«INFN Grid» (Italy's National Institute for Nuclear Physics: http://grid.infn.it/)

«INFN Grid» (Italy's National Institute for Nuclear Physics: http://grid.infn.it/)

Проект «INFM Grid» – детище Итальянского института ядерных исследований. Основная цель проекта – разработка программного обеспечения для построения и использования ГРИД-сетей. Важной особенностью данного проекта является широкое использование и активное участие в разработке программного обеспечения «Grid2Win» (http://grid2win.gilda-forge.ct.infn.it). ПО Grid2Win» является попыткой переноса общеизвестного ПО для ГРИД «gLite» на Windows-платформу.

«C-OMEGA» (The Grid for Industry, Commerce and Public: http://www.c-omega.org)

«C-OMEGA» (The Grid for Industry, Commerce and Public: http://www.c-omega.org)

Проект «C-OMEGA» создан для разработки, интеграции и промышленного использования ГРИД сервисов в коммерческих интересах.

В большей части проект является организационным и прямо связан с проектом INFN Grid.

Австрия

«AUSTRIAN GRID» (http://www.austriangrid.at)

«AUSTRIAN GRID» (http://www.austriangrid.at)

Австрийский проект ГРИД организован с помощью Министерства по образованию, культуре и науке и направлен на развитие общей инфраструктуры ГРИД в Австрии, разработку нового ПО для ГРИД и международного сотрудничества. Участниками проекта являются практически все основные научные центры Австрии, университеты, государственные службы.

Болгария

BGrid (http://www.grid.bas.bg)

BGrid (http://www.grid.bas.bg)

В Болгарии ГРИД-консорциум образован при Институте параллельных вычислений Болгарской Академии наук. Занимается исследованиями параллельных вычислений и вопросами участия в различных европейских проектах. Полностью базируется на инфраструктуре указанного института.

Ирландия

Grid-Ireland (http://www.grid.ie)

Grid-Ireland (http://www.grid.ie)

Проект объединяет все крупные университеты и научно-исследовательские центры Ирландии. Использует собственную высокопроизводительную сетевую инфраструктуру (Higher Education Authority Network – HEAnet). Основными потребителями являются научные сообщества, которые проводят фундаментальные исследования.

Норвегия

![]() NORGRID (http://www.norgrid.no)

NORGRID (http://www.norgrid.no)

Норвежский проект инициирован правительством и предназначен для скорейшего построения ГРИД-инфраструктуры Норвегии. Существующая инфраструктура базируется на вычислительных центрах основных университетов и правительства, а также подключена к европейским проектам EGEE и DEISA.

Турция

![]() TR-Grid (http://www.grid.org.tr)

TR-Grid (http://www.grid.org.tr)

В Турции создание ГРИД-инфраструктуры проходит в рамках программ университетов и академий, как основных центров развития инноваций и науки. Проект TR-Grid поддерживается государством и подключен к другим европейским проектам.

Китай

![]() CNGrid (http://www.cngrid.org/)

CNGrid (http://www.cngrid.org/)

Национальный проект CNGrid в Китае инициирован и поддерживается правительством. Создан при активной поддержке и на решениях IBM. Является одним из наиболее крупных ГРИД-проектов и сетей в Юго-Восточной Азии. Официально используется университетами Китая для фундаментальных и прикладных исследований.

Россия

RDIG (www.eu-rdig.org)

RDIG (www.eu-rdig.org)

ГРИД-инфраструктура ОИЯИ функционирует в составе глобальной ГРИД-системы EGEE (Enabling Grids for E-sciencE) и проекта WLCG (World LHC Computing GRID), основной задачей которого является создание инфраструктуры региональных центров для обработки, хранения и анализа данных физических экспериментов LHC. ОИЯИ участвует в этом проекте с 2003 г., когда было подписано соглашение между ЦЕРН, Россией и ОИЯИ об участии в проекте LCG (впоследствии WLCG). В 2007 г. протестированы выделенные каналы связи между ОИЯИ и Tier1 центрами для экспериментов ATLAS, CMS и ALICE.

Ключевым моментом развития ГРИД в России является эволюция внешних телекоммуникационных каналов связи (Рис. 5). В настоящий момент ведутся работы по расширению канала Дубна – Москва до 10 Гбит/с (сейчас пропускная способность 1 Гбит/с). Сетевая информационно-вычислительная инфраструктура ОИЯИ – это распределенный программно-аппаратный комплекс, использующий специализированное программное обеспечение и многофункциональное оборудование. Ядром этой инфраструктуры является Центральный информационно-вычислительный комплекс (ЦИВК) ОИЯИ. Базисом инфраструктуры является локальная сеть ОИЯИ, объединяющая информационно-вычислительные ресурсы института в единую информационно-вычислительную среду. Ресурсы этой среды доступны для всех пользователей ОИЯИ, в том числе с использованием ГРИД-технологий. На ее основе через телекоммуникационные каналы связи осуществляется предоставление удаленного доступа в российские и зарубежные научные сети и обеспечение удаленного доступа к ресурсам института.

В 2007 г. производительность ЦИВК ОИЯИ существенно увеличена и содержит системы дисковых массивов объемом 56 ТВ. Ресурсы ЦИВК используются участниками экспериментов E391A (KEK), COMPASS, D0, DIRAC, HARP, CMS, ALICE, ATLAS, HERAb, H1, NEMO, OPERA, HERMES, CBM, PANDA и др. для моделирования физических процессов и анализа экспериментальных данных. Предусмотрено наращивание производительности ЦИВК ОИЯИ и систем хранения данных для обеспечения потребностей обработки данных для LHC экспериментов и других экспериментов с участием ОИЯИ; развитие и сопровождение базового программного обеспечения.

Состав вычислительных ресурсов: 53 сервера, 7 узлов. 60 четырехядерных узла, Xeon 5150, 8GB RAM; 6 двуядерных, Athlon , 2GB RAM, Mirynet. Используемые ОС: Scientific Linux 4.4, Scientific Linux CERN 4.5; Middleware – gLite-3.1. Файловая система – AFS (the Andrew File System) Система регистрации пользователей – Kerberos 5 (AFS use Kerberos 5).

Резюме

Существующая ситуация вокруг развития ГРИД в мире показывает, что инициатива, поддержка и развитие ГРИД-инфраструктур в мире происходит при активном участии государства. Такая работа проводится либо специально создаваемыми межведомственными комитетами, либо одним из министерств.

Важным моментом является тот факт, что во всех случаях сама сеть ГРИД создается на базе и инфраструктуре университетов и научно-исследовательских центров. Это позволяет достичь максимальной эффективности в научной деятельности, общем развитии материальной базы и процессе обучения.

Распределение сил в мире ГРИД

Два гиганта – Америка и европейский ГРИД-союз – успешно работают и развиваются. К американской системе подключаются канадская, латиноамериканская ГРИД-сети, а в европейском союзе основные силы представляют Великобритания и Германия.

К сожалению, Россия в области ГРИД практически на последнем месте. При наличии значительного числа крупных вычислительных центров, с установленными в них суперкомпьютерами, а также при имеющейся серьезной научной школе тематика ГРИД выражена лишь опосредованным участием в общеевропейском проекте для большого коллайдера.

На сегодня основной задачей для России должно стать активное участие государства в развитии общенациональной системы ГРИД, утверждением и распространением концепции развития этой тематики. И медлить здесь нельзя.

Подписаться

Подписаться Читать в телеграм

Читать в телеграм