1. Причины появления SAN

Появление в конце 80-х годов серверов, построенных по открытым технологиям и сопоставимых по производительности с мэйнфреймами, стимулировало разработку приложений, в первую очередь СУБД, и расширение их применения в крупном и среднем бизнесе.

Развитие СУБД и переход к клиент-серверной архитектуре позволили решать новые задачи, что привело к резкому росту объемов обрабатываемых данных. В этот период основным средством доступа серверов к устройствам хранения данных являлась технология SCSI, которая имеет принципиальные ограничения:

- Возможна только одна топология – шина;

- Ограничено число подключаемых устройств – 15;

- Ограничена длина шины – 25 метров;

- Используется толстый экранированный медный кабель, неудобный для прокладки.

В 1988 году началась разработка нового протокола с целью создания технологии для подключения устройства хранения данных к серверам, не имеющей ограничений, присутствующих в технологии SCSI. Изначально в Fibre Channel его авторами закладывались сетевые возможности.

За шесть лет удалось разработать новую продуманную технологию передачи данных, позволяющую создавать сети, соединяющие серверы и устройства хранения. В 1994 году была принята первая редакции стандарта Fibre Channel, являющегося основой сетей хранения данных (Storage Area Network – SAN).

В то же время, изменившиеся условия бизнеса (круглосуточная работа, мобильность и т.д.) и возросшая роль информационных технологий ужесточили требования эксплуатации вычислительных комплексов. Резкий рост объемов данных, появление больших дисковых массивов и сокращение допустимого времени простоя потребовали от производителей оборудования обеспечения быстрого и надёжного доступа серверов к устройствам хранения данных, добавления в систему новых устройств хранения данных без остановки системы, ускорения резервного копирования и восстановления данных с резервной копии.

И хотя к этому моменту уже существовали решения указанных задач на основе различных протоколов, таких как, например, IBM SSA (Serial Storage Architecture), выбор был сделан в пользу Fibre Channel, который иногда называют «мускулатурой SAN» или как говорят американцы «the 800-pound gorilla of SANs». Данный выбор был обусловлен тем, что протокол Fibre Channel являлся открытым стандартом, уже применявшимся на практике и имевшим большие сетевые возможности, а также существовало большое количество производителей (Brocade, QLogic, JNI, Vixel, Crossroads и т.д.) компонентов SAN, основанных на Fibre Channel (FC-HBAs, FC-концентраторы, FC-коммутаторы, программное обеспечение управления).

2. Задачи, которые позволяет решать SAN

С помощью технологии SAN удается повысить скорость передачи данных и надежность соединений за счет высокой пропускной способности и низких накладных расходов (overhead) протокола Fibre Channel, двунаправленной передачи данных и применения коммутации соединений.

Создав SAN можно обеспечить доступ к устройствам хранения, находящимся на большом расстоянии от серверов, с минимальной потерей производительности. Это достигается благодаря тому, что при создании протокола Fibre Channel в него закладывалась возможность передавать данные между серверами и устройствами хранения по оптоволоконным линиям с большой скоростью на десятки километров.

Подключение новых серверов и дисковых массивов к SAN можно осуществлять без остановки системы. Поскольку SAN является сетью, то в ней реализованы методы подключения новых устройств, аналогичные по своей функциональности тем, что присутствуют в ЛВС. Эти методы позволяют автоматически распознавать появление и отключение новых устройств в сети, производить её реконфигурацию.

С помощью подключения ленточных библиотек к серверам через SAN удаётся ускорить резервное копирование и восстановление данных с резервной копии. Действительно, трафик резервного копирования переводится из IP-сети в SAN, ориентированную на скоростную передачу больших объемов данных. При включении в SAN каждый сервер имеет доступ к ленточной библиотеке, также подключенной к SAN, и может передавать данные резервного копирования напрямую на выделенный ему ленточный привод.

Высокая пропускная способность SAN обеспечивает скоростную репликацию данных с помощью как программных, так и аппаратных средств. Низкие, по сравнению с IP-сетью, накладные расходы Fibre Channel и высокое быстродействие позволяют выполнять синхронную репликацию данных с минимальной латентностью, влияющей на доступ серверов к исходным томам данных. Дисковые массивы высшего класса могут выполнять по SAN репликацию дисковых томов друг с другом с помощью встроенных программных средств, прозрачно для серверов.

Кроме того, SAN позволяет использовать приобретенные ранее устройства совместно с новыми устройствами хранения данных. Дисковые массивы и ленточные библиотеки, не оборудованные интерфейсами Fibre Channel, можно подключить к SAN используя маршрутизаторы Fibre Channel-SCSI.

3. Архитектура SAN

3.1 Что такое SAN?

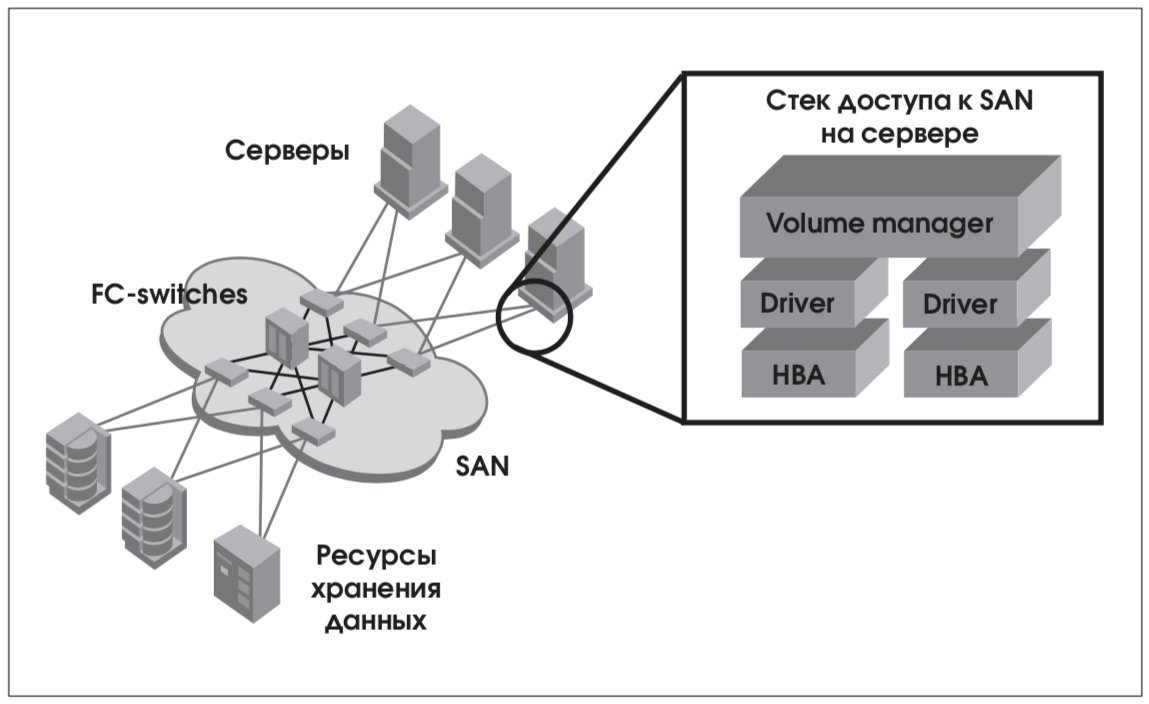

SAN является высокоскоростной сетью передачи данных, предназначенной для подключения серверов к устройствам хранения данных. Разнообразные топологии SAN (точка-точка, петля с арбитражной логикой (Arbitrated Loop) и коммутация) замещают традиционные шинные соединения «сервер-устройства хранения» и предоставляют по сравнению с ними большую гибкость, производительность и надежность (Рис. 1). В основе концепции SAN лежит возможность соединения любого из серверов с любым устройством хранения данных, работающим по протоколу Fibre Channel. Принцип взаимодействия узлов в SAN c топологиями точка-точка или коммутацией очевиден. В SAN с топологией Arbitrated Loop передача данных осуществляется последовательно от узла к узлу. Для того, чтобы начать передачу данных передающее устройство инициализирует арбитраж за право использования среды передачи данных (отсюда и название топологии – Arbitrated Loop).

3.2 Технологическая основа SAN – протокол Fibre Channel

Транспортную основу SAN составляет протокол Fibre Channel, использующий как медные (до 25 метров), так и волоконно-оптические соединения устройств (до 10 километров), обеспечивающий в настоящее время скорость передачи данных, равную 400 Мбайт/с в дуплексном режиме. Уже объявлено о работе над новыми редакциями стандарта для скоростей 800Мбайт/с и 2Гбайта/с (с учетом двунаправленной передачи данных). На сегодняшний день уже можно строить сети с большой удаленностью между соединяемыми объектами (до 120 километров с использованием специальных технологий).

Оптоволокно используется значительно чаще, поэтому для построения большой полноценной SAN нужно проектировать оптоволоконную кабельную сеть (как для Gigabit Ethernet). Без нормальной кабельной сети подключение устройств к SAN становится очень трудоемкой задачей, а количество проводов – соизмеримым с ЛВС.

3.3 Компоненты SAN

Компоненты SAN подразделяются на следующие:

- Host Bus Adaptors (HBA);

- Ресурсы хранения данных;

- Устройства, реализующие инфраструктуру SAN;

- Программное обеспечение.

HBA устанавливаются в серверы и осуществляют их взаимодействие с SAN по протоколу Fibre Channel. Стек протоколов Fibre Channel реализован внутри HBA. Наиболее известными производителями HBA являются компании Emulex, JNI, Qlogic и Agilent. Производители серверов часто используют под своим именем HBA этих компаний.

К ресурсам хранения данных относятся дисковые массивы, ленточные приводы и библиотеки с интерфейсом Fibre Channel. Многие свои возможности ресурсы хранения реализуют только будучи включенными в SAN. Так дисковые массивы высшего (high-end) класса могут осуществлять репликацию данных между массивами по сетям Fibre Channel, а ленточные библиотеки могут реализовывать перенос данных на ленту прямо с дисковых массивов с интерфейсом Fibre Channel, минуя сеть и серверы (Serverless backup). Наибольшую популярность на рынке приобрели дисковые массивы компаний EMC, Hitachi, IBM, Compaq (семейство StorageWorks, доставшееся Compaq от Digital), а из производителей ленточных библиотек следует упомянуть StorageTek, Quantum/ATL, IBM.

Устройствами, реализующими инфраструктуру SAN, являются коммутаторы Fibre Channel (Fibre Channel switches, FC-switches), концентраторы (Fibre Channel Hub) и маршрутизаторы (Fibre Channel-SCSI routers).

Концентраторы используются для объединения устройств, работающих в режиме Fibre Channel Arbitrated Loop (FC_AL). Применение концентраторов позволяет подключать и отключать устройства в петле без остановки системы, поскольку концентратор автоматически замыкает петлю в случае отключения устройства и автоматически размыкает петлю, если к нему было подключено новое устройство. Каждое изменение петли сопровождается сложным процессом её инициализации. Процесс инициализации многоступенчатый, и до его окончания обмен данными в петле невозможен. Топология FC_AL имеет и другие ограничения. Так, например, петля может содержать не более 126 устройств, процесс её инициализации занимает много времени и производительность петли уменьшается с увеличением числа устройств.

Из-за этих ограничений в настоящий момент топология FC_AL и концентраторы применяются редко, однако концентраторы иногда можно встретить на периферии SAN.

Все современные SAN построены на коммутаторах, позволяющих реализовать полноценное сетевое соединение. Коммутаторы могут не только соединять устройства Fibre Channel, но и разграничивать доступ между устройствами, для чего на коммутаторах создаются так называемые зоны (Zones). Устройства, помещенные в разные зоны, не могут обмениваться информацией друг с другом.

Количество портов в SAN можно увеличивать, соединяя коммутаторы друг с другом. Группа связанных коммутаторов носит название Fibre Channel Fabric или просто Fabric. Связи между коммутаторами называют Interswitch Links или сокращенно ISL.

Коммутаторы, которые не обладают возможностью составлять Fabric или обладают ограниченными возможностями (например, на коммутаторе может быть только один ISL), называют коммутаторами начального уровня.

К коммутаторам класса Director относятся модульные коммутаторы с числом портов больше 64-х. Все компоненты коммутатора класса Director такие, как блоки питания, вентиляторы, управляющие процессоры и модули коммутации, продублированы. Большинство из них можно заменить без остановки системы. Коммутатор класса Director является высоко надежным устройством, поэтому его можно применять в SAN в одном экземпляре.

Наиболее известны на рынке в качестве производителей коммутаторов Fibre Channel компании Brocade, Qlogic, McDATA и InRange.

Маршрутизаторы Fibre Channel-SCSI предназначены для подключения к SAN устройств, не оборудованных интерфейсами Fibre Channel, таких как старые дисковые массивы и ленточные библиотеки. Для выполнения процедур Serverless backup (см. далее) в маршрутизаторы Fibre Channel-SCSI встроены механизмы переноса данных с дисков на ленту на уровне блоков. Маршрутизаторы Fibre Channel-SCSI представлены на рынке моделями производства компаний Crossroads и ADIC.

Программное обеспечение позволяет реализовать резервирование путей доступа серверов к дисковым массивам и динамическое распределение нагрузки между путями. Для большинства дисковых массивов существует простой способ определить, что порты, доступные через разные котроллеры, относятся к одному диску. Специализированное программное обеспечение поддерживает таблицу путей доступа к устройствам и обеспечивает отключение путей в случае аварии, динамическое подключение новых путей и распределение нагрузки между ними. Как правило, изготовители дисковых массивов предлагают специализированное программное обеспечение такого типа для своих массивов. Компания VERITAS Software производит программное обеспечение VERITAS Volume Manager, предназначенное для организации логических дисковых томов из физических дисков и обеспечивающее резервирование путей доступа к дискам, а также распределение нагрузки между ними для большинства известных дисковых массивов. VERITAS Volume Manager работает на платформах Solaris/SPARC, HP-UX, AIX, Windows NT/2K и Linux.

Значительную роль играет программное обеспечение в резервном копировании через SAN. Рассмотрим, например, процедуру Serverless backup.

Непосредственный перенос данных с дисковых массивов на ленту производится на уровне физических дисковых блоков. Перед выполнением резервного копирования программное обеспечение формирует таблицу дисковых блоков, относящихся к тем логическим структурам (файловым системам, файлам баз данных), которые подлежат резервному копированию. Для получения целостного непротиворечивого образа данных на ленте необходимо, чтобы в процессе резервного копирования перемещаемые на ленту блоки данных оставались неизменными. Таблица соответствия физических блоков и логических структур также записывается на ленту и используется при восстановлении данных.

Наиболее известными средствами резервного копирования, работающими в SAN, являются VERITAS Netbackup, Legato NetWorker, Tivoli Storage Manager и HP Omniback II.

Программное обеспечение используется также для управления SAN – отображения топологии, управления зонами на коммутаторах, обнаружения отказов устройств в SAN, сбора статистики производительности и т.д. К наиболее распространенному программному обеспечению управления SAN (и системами хранения) можно отнести VERITAS SANPoint Control, BMC PATROL Storage Management, McDATA SANavigator, Tivoli Storage Network Manager.

В последнее время все популярнее становится внедрение средств виртуализации дисковых ресурсов в SAN. Идея виртуализации состоит в том, чтобы обеспечить представление серверам ресурсов хранения в виде, независимом от используемых дисков или дисковых массивов. В идеале серверы должны «видеть» не устройства хранения данных, а ресурсы.

Технически идея реализуется следующим образом: между серверами и дисковыми устройствами помещается специальное устройство виртуализации, к нему с одной стороны подключаются дисковые устройства, а с другой – серверы. На устройстве виртуализации содержатся правила преобразования физических ресурсов хранения данных в логические, которыми оперируют серверы.

Недостатком такого решения является то, что серверы взаимодействуют с устройствами хранения только через устройство виртуализации и в случае выхода его из строя все ресурсы хранения становятся недоступны для серверов. Помимо этого становится сложным использование внутренних процедур дисковых массивов (создание копии данных внутри массива, удаленная репликация), поскольку истинная структура данных скрыта от серверов.

В ближайшем будущем ожидается появление нового поколения средств виртуализации. Ожидается, что средства виртуализации начнут встраиваться внутрь HBA и коммутаторов. Устройство виртуализации станет специальным сервисом внутри коммутатора. HBA будут получать от сервиса виртуализации правила трансляции логических устройств хранения в физические и потом работать с физическими устройствами непосредственно.

Среди производителей устройств виртуализации следует упомянуть компании Datacore, Vicom и VERITAS Software. Многие крупные производители продают продукцию этих компаний под своим именем.

4. Примеры решений на основе SAN

Возможности обсуждаемой технологии лучше всего проиллюстрировать на примерах построения SAN в небольших, средних и крупных организациях.

4.1 SAN начального уровня – эффективное использование дискового пространства

Рассмотрим ситуацию, когда в организации эксплуатируется информационная система, состоящая из одного UNIX-сервера и нескольких NTсерверов. Все серверы хранили свои данные на локальных дисках. Ёмкости и производительности дисковой подсистемы UNIX-сервера стало не хватать для выполнения производственных задач, поэтому встала необходимость приобрести новый дисковый массив с высокой производительностью и надежностью.

Современные дисковые массивы, удовлетворяющие указанным требованиям, как правило, оборудуются интерфейсами Fibre Channel и обладают большой емкостью. Выбранный в данном случае из соображений производительности и надежности дисковый массив имел емкость 600 Гб, тогда как для задач UNIX-сервера требовалось только 80-100 Гб. Но в то же время и NTсерверам были нужны дополнительные дисковые ресурсы.

Подходящим решением стало создание небольшой SAN, построенной на двух 8-ми портовых FC-коммутаторах начального уровня, для доступа всех серверов к дисковому массиву.

Создание SAN позволило расширить дисковое пространство для всех серверов и обеспечить их доступ непосредственно к дисковому массиву. Теперь решена проблема, когда у одного из серверов не хватает дисковых ресурсов, а у другого – есть свободное дисковое пространство и невозможно его передать первому серверу, поскольку диски локальные.

В результате небольших вложений в SAN (коммутаторы и HBA) создана сетевая инфраструктура, которая при дальнейшем расширении комплекса – увеличении объема данных и числа задач, дает возможность увеличивать количество подключаемых серверов и дисковых массивов без остановки системы (Рис. 3).

4.2 Резервное копирование через SAN – повышение производительности

Рассмотрим другой пример. В компании среднего масштаба эксплуатировалась система, состоящая из нескольких серверов. Все серверы хранили свои данные на локальных дисках. Резервное копирование производилось классически – по ЛВС на ленточную библиотеку, подключенную напрямую к одному из серверов с наибольшим объемом данных. За период существования системы значительно возрос объём обрабатываемых данных. Из-за большого объема данных время резервного копирования перестало укладываться в отведенное окно. Трафик резервного копирования мешал выполнению производственных задач (Рис. 4).

Проблема была решена путем создания SAN резервного копирования. Для чего установили один FC-коммутатор и подключили к нему ленточную библиотеку и серверы. Данные резервного копирования передаются с серверов непосредственно на ленточную библиотеку через SAN.

В этом случае сократилось время резервного копирования, и оно стало укладываться в отведенное окно, трафик резервного копирования перестал мешать выполнению производственных задач.

Если в комплексе до внедрения SAN выходил из строя сервер, к которому была подключена ленточная библиотека, то её приходилось перетаскивать и подключать к другому серверу. С внедрением SAN необходимость в этом отпала – все серверы имеют доступ к ленточной библиотеке.

При дальнейшем росте объёмов обрабатываемых данных возможна установка дополнительных ленточных приводов в библиотеку или приобретение новой с подключением её в SAN. При этом новые приводы будут доступны всем серверам комплекса.

С увеличением числа решаемых задач и объёмов данных потребуется установка новых серверов и дисковых массивов. Существующая SAN резервного копирования может быть легко преобразована в полномасштабную SAN, которая позволит подключать новые дисковые массивы и серверы без остановки системы.

4.3 Централизованная система хранения на основе SAN – обеспечение наращивания системы и простоты эксплуатации

На примере крупного вычислительного центра (ВЦ) рассмотрим способ модернизации системы хранения путем построения SAN. В указанном вычислительном центре существовала централизованная система хранения данных на базе двух дисковых массивов, подключенных напрямую к большому количеству серверов. Резервное копирование данных осуществлялось по ЛВС на ленточную библиотеку, подключенную напрямую к серверу, обрабатывавшему наибольший объем данных.

При подключении нового массива непосредственно к имеющимся серверам необходимо было добавлять в каждый сервер минимум два адаптера Fibre Channel. Это значительно усложняло структуру кабельной сети, поэтому серверы подключались только к тем массивам, где хранили свои данные.

Дальнейшее развитие бизнеса требовало увеличения емкости ресурсов хранения и подключения новых серверов, поэтому было принято решение модернизировать систему хранения данных путем создания SAN.

Из-за большого числа портов (42) SAN строится на базе коммутатора класса Director (FC-Director). FC-Director содержит 64 порта (с возможностью расширения до 128). Все компоненты (блоки питания, вентиляторы, управляющие процессоры, модули коммутации) FCDirector продублированы, и большую их часть можно заменить без остановки системы. FCDirector является достаточно надежным устройством, что дает возможность использовать его в одном экземпляре.

SAN позволяет подключить все необходимые ресурсы, значительно упростить структуру кабельной сети и предоставляет большие возможности для дальнейшего расширения (Рис. 5).

4.4 SAN между основным и резервным центром – повышение надежности и простоты эксплуатации

Fibre Channel дает возможность работать на больших расстояниях, что позволяет применить технологию SAN для объединения основного и резервного центров. Рассмотрим это на следующем примере. В крупной компании были построены основной и резервный центры, соединенные по IP-сети. Резервное копирование данных производилось в каждом из центров независимо.

Из-за больших накладных расходов IP-сети репликация выполнялась с промежутком в асинхронном режиме. Развивающийся бизнес повысил требования к надежности вычислительного центра (ВЦ) компании. Актуальность копий данных в резервном центре, получаемых с помощью асинхронной репликации по ЛВС, не соответствовала изменившимся требованиям бизнеса (Рис. 6).

Помимо этого наличие двух независимых систем резервного копирования значительно усложняло процесс эксплуатации, процедуры резервного копирования и восстановления данных.

Для решения указанных проблем основной и резервный центры объединили между собой единой сетью хранения данных.

Создание SAN увеличило скорость и объемы передачи данных между центрами. Это позволило использовать синхронный метод репликации данных и добиться того, чтобы актуальность информации в резервном центре не отличалась от основной площадки.

Основной и резервный центры имеют прямой доступ к дисковым массивам и ленточным библиотекам друг друга, которые образуют единое пространство хранения данных. Это дало возможность создать единую систему резервного копирования, что существенно упростило эксплуатацию комплекса.

5. Практические советы (Best Practice)

5.1 Тестирование решений

По разным причинам (отсутствие у одного производителя полного набора необходимых компонентов, большой цены решения «из одних рук» и т.п.) часто приходится объединять решения разных производителей. В таких случаях необходимо тестировать совместимость компонентов создаваемого комплекса. SAN – не исключение.

В настоящий момент почти все SAN-компоненты разных производителей совместимы друг с другом и могут работать вместе. Цель тестирования – найти оптимальные режимы оборудования, проверить работу ключевых приложений в новых условиях и т.д. (Рис. 7).

В Техническом Центре компании «Инфосистемы Джет» при разработке решений или по запросу заказчиков производится тестирование SAN-конфигураций с целью выбора оптимальных, с минимумом потенциальных проблем в процессе реализации и эксплуатации. На рисунках 8 и 9 изображены состояния стенда SAN в различные моменты времени.

В качестве программного обеспечения для реализации альтернативных путей доступа и распределения нагрузки можно рекомендовать VERITAS Volume Manager для платформ Sun Solaris/SPARC, HP-UX, AIX, Linux и NT/Win2K.

В случае создания Fabric из нескольких коммутаторов важно подобрать правильное количество соединений между коммутаторами. Из практических соображений количество соединений выбирается в зависимости от числа активных одновременных обменов, происходящих между устройствами, включенными в разные коммутаторы. Так, если у Вас имеются две пары активно работающих устройств, то создавать три связи между коммутаторами бессмысленно – одна связь будет всегда незагружена (это связано с особенностью алгоритма маршрутизации пакетов между коммутаторами). Желательно, чтобы число активных одновременных обменов было кратно числу связей между коммутаторами.

Обычно число связей между коммутаторами в Fabric рекомендуется делать 2 и более из соображений надежности.

На рисунках 10 и 11 в качестве иллюстрации применения рекомендаций на практике изображены схемы SAN, реализованные у двух крупных заказчиков компании «Инфосистемы Джет».

Первая сеть построена как Dual fabric из 6ти коммутаторов – 4-х центральных коммутаторов и 2-х периферийных. Между основной и резервной площадками центральные коммутаторы в обеих Fabric объединены через 2 ISL. Все сервера и дисковые массивы подключены в каждую из Fabric. С целью экономии портов на центральных коммутаторах и в связи с особенностью FC-ленточной библиотеки, для её подключения к серверам были использованы периферийные коммутаторы. Ленточные устройства библиотеки подключены в два периферийных коммутатора.

Во второй сети также присутствуют центральные и периферийные коммутаторы, однако в качестве центрального коммутатора используется FC-Director. Все серверы и дисковые массивы подключены двумя соединениями в центральный коммутатор. Также как и в предыдущем примере с целью экономии портов на центральном коммутаторе для подключения ленточных устройств библиотеки в SAN были использованы два периферийных коммутатора.

6. Заключение

Путь от идеи SAN до появления первых работающих образцов был достаточно долог. Но этап совершенствования технологии до возможности использования в промышленной эксплуатации сети хранения данных прошли быстро и легко. Если первые устройства требовали тщательной настройки, то сейчас они требуют намного меньшего вмешательства для подключения и запуска. Технология SAN продолжает развиваться с нарастающей скоростью – внедрение 2-х гигабитного протокола Fibre Channel и появление на рынке поддерживающих его устройств заняло меньше 2-х лет.

На сегодняшний день все большее число систем хранения данных в вычислительных центрах строятся на основе SAN. Для подключения к серверам дисковых массивов высшего и среднего классов повсеместно используется Fibre Channel.

Конечно же, для создания SAN, как и для ЛВС, необходимо проводить проектирование, однако создание SAN уже не является уникальным новаторским решением. Необходимо задать себе вопрос: стоит ли при модернизации или создании новой системы хранения данных вкладывать средства в устаревшие технологии или уже сегодня начать внедрять SAN, чтобы не отстать завтра.

Сегодня с уверенностью можно констатировать, что SAN стала неотъемлемой частью современных вычислительных центров, является отработанным решением и продолжает развиваться.

Подписаться

Подписаться Читать в телеграм

Читать в телеграм