Закат алгоритмического мышления

Пожалуй, одним из самых ярких технологических событий 2017 года стал мощный выход систем искусственного интеллекта (Artificial Intelligence, AI) и машинного обучения (Machine Learning, ML) из узких нишевых сфер: распознавания речи или моделирования поведения виртуальных игроков компьютерных игр на широкое поле корпоративных приложений.

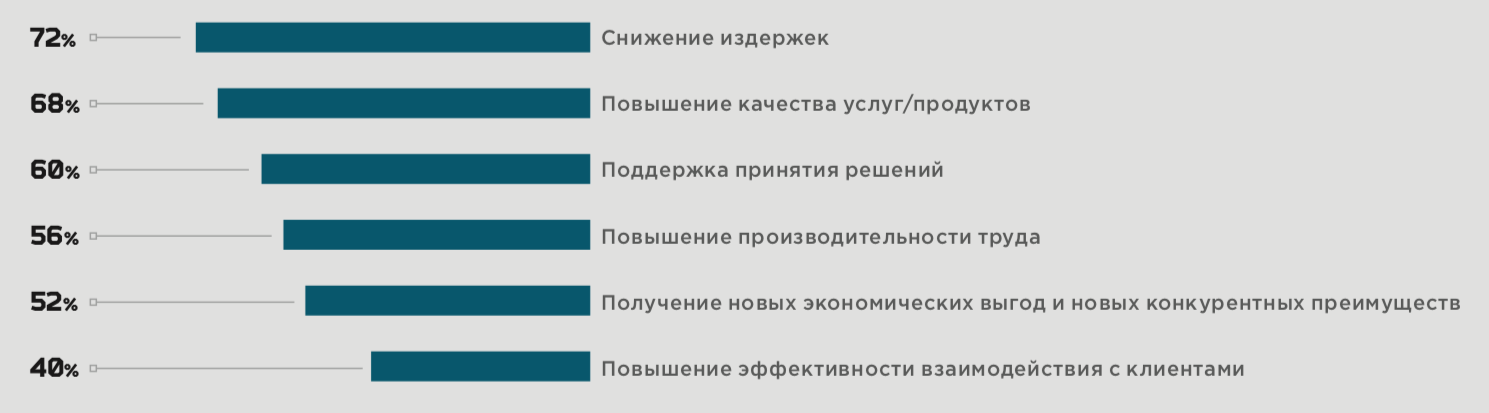

Потенциальных пользователей такое положение дел явно радует — более половины респондентов, опрошенных в рамках исследования по заказу компании «Инфосистемы Джет» уверены, что их затраты на AI/ML в ближайшие 3–5 лет будут расти, причем, примерно треть опрошенных называет цифру 15–20% в год.

А представители крупных банков полагают, что через 5 лет около 80% всех решений будут приниматься с помощью искусственного интеллекта и прогнозируют, что отрасль начнет активно переходить на безлюдные технологии. Ожидается, что через три года клиенты, обращающиеся в банк по самым разным поводам, в половине случаев будут общаться с программными ботами, а не человеком-сотрудником.

Технологии машинного обучения идут в те области, в которых уже сегодня работают умные алгоритмы: прогнозируют поведение клиента, формируют персонализированные рекомендации для покупки товара, рассчитывают параметры кредитного скоринга, выявляют фрод и т.д. Причина в том, что технологии ML оказываются гораздо более гибкими и расторопными в настройке на новые параметры бизнес-среды. В частности, в ритейле был отмечен рост конверсии до 15% при использовании товарных рекомендаций на базе машинного обучения. А количество ручных операций при этом может сократиться до 50 раз. Основные сферы применения искусственного интеллекта представлены на рисунке 1.

- По оценкам MGI, потенциальный экономический эффект от повышения производительности труда с помощью автоматизации интеллектуальных задач составит к 2025 году от 5,3 до 6,7 трлн долл. ежегодно.

- Согласно данным исследования, которое проводилось по заказу компании «Инфосистемы Джет» в преддверии форума RAIF-2017, российский рынок решений ML и AI вырастет к 2020 г. до 28 млрд руб.

- По оценкам Gartner, искусственный интеллект к 2020 г. создаст больше рабочих мест, чем уничтожит: 2,3 млн дополнительных рабочих мест против 1,8 млн ликвидированных.

О выходе на уровень коммерческих решений для корпоративного рынка можно говорить применительно к системам, способным в режиме реального времени обрабатывать информацию из множества источников, агрегировать разрозненные данные в более общие конструкции и выявлять некоторые закономерности, то есть самостоятельно делать некоторые логические заключения. Например, такие программы умеют готовить маркетинговые или отраслевые отчеты на основании анализа данных, автоматически собираемых из технических документов и других источников.

Даже если компьютерные программы будут стремительно умнеть, это не избавит корпоративный ИТ–департамент от традиционной головной боли — интеграции разрозненных информационных систем в единую слаженную информационную структуру. Решение этой проблемы символизирует переход к цифровым платформам.

Яркий пример — цифровая платформа Jet Detective — универсальное антифрод–решение, в основе которого лежат технологии машинного обучения и искусственного интеллекта для автоматизированного анализа событий. Система работает с объектами и анализирует все события, происходящие с ними, в терминах объектов и характеристиках поведения этих объектов.

Иными словами, платформа, не имеет отраслевой привязки, ее с равным успехом можно использовать для борьбы с фродом в банке, в ритейле и других областях, где необходим контроль поведения любых объектов. Jet Detective сам отличит объект «Клиент 1» в ритейла от объекта «Клиент 2» в банках, а также определит эффективные механизмы их оценки в соответствующей отрасли.

Как в озере сырых данных поймать рыбу ценной породы?

Анализ больших массивов данных (Big Data) — это, пожалуй, один из самых мощных технологических трендов, который будет все сильнее менять формат ведения любого бизнеса. При этом сами «виновники» очередной революции — информационные технологии — станут незаметными для конечного потребителя цифровых услуг, а Интернет — просто транспортной сетью. Этот феномен, известный как «коммодитизация ИТ», подразумевает, что информационные системы, хранящие различные данные, становятся подобны цифровым недрам: большую часть человечества интересует практические результаты работы этих систем, а не само обращение данных в этом информационном мире. Консалтинговая компания Deloitte называет это явление «Все как услуга» (Everything As A Service, EaaS) и относит к числу наиболее мощных технологических трендов, которые определяют потребность в появлении гибких платформенных архитектур.

Наибольшую ценность будут иметь результаты обработки данных, а также источники достоверных актуальных данных. Большими объемами достоверных данных о гражданах уже владеют как госструктуры, так и крупные частные компании. Эти сведения становятся привлекательным товаром на соответствующих рынках. Иными словами, частная жизнь человека вскоре станет абсолютно прозрачной, поскольку автоматическая интеграция данных из различных источников даст возможность формировать любые профили рабочей деятельности, социального поведения, бытовых наклонностей любого человека с любой степенью детальности и точности. Например, уже сегодня американская компания Acxiom предлагает своим клиентам профили более чем полумиллиарда потенциальных пользователей. Такой профиль содержит набор вероятных характеристик и интересов пользователя, полученный на основании обработки триллионов действий посетителей сайтов, совершаемых ежегодно.

Осознание величайшей ценности таких сведений стимулирует дискуссии в обществе о контроле над обращением персональных данных, а рыночные игроки стараются обнаружить коммерчески доходные ниши услуг анализа Больших данных. Сегментация и персонализация — вот, пожалуй, наиболее очевидные направления применения таких инструментов в маркетинге коммерческих компаний.

С точки зрения ИТ, эти процессы ассоциируются с двумя традиционными компьютерными направлениями: высокопроизводительной аналитикой данных (High Performance Data Analytics, HPDA) и с обработкой интенсивных данных (Data Intensive Systems), описывающая приложения с интенсивным и нерегулярным доступом. Оба направления находят свое отражение в аналитике Больших данных, однако сами по себе не обеспечивают требуемую поддержку задач анализа Big Data. В частности, системы технологии высокопроизводительных вычислений (High Performance Computing, HPC), являющиеся основой высокопроизводительной аналитики HPDA, обычно используют высокоскоростные сети, параллельные файловые системы и бездисковые вычислительные узлы. А системы, ориентированные на обработку больших объемов данных, поступающих из различных источников, наоборот, могут использовать относительно медленные сети, локальные файловые системы и дисковые узлы хранения.

Осознание этих архитектурных противоречий стимулировало интерес к распределенным файловым системам на кластерах. Важное событие произошло в 2002 г. Тогда Дуг Каттинг, отец–основатель платформы Hadoop, искал файловую систему для создаваемого с нуля проекта Nutch, включающего Hadoop. Он решил взять за основу идеи GFS (Google File System) и реализовал систему с открытым кодом NDFS (Nutch Distributed File Systems), которая в последствие стала называться HDFS. Это было хорошим решением с практической точки зрения — система была достаточно простой в реализации, идеально сочеталась с MapReduce и обеспечивала надежное хранение файлов большого объема, которые не могли поместиться в памяти одного узла. Сегодня ПО Hadoop, позволяющее собирать, управлять, сортировать данные корпоративных приложений и готовить их для обработки аналитическими системами, стало стандартом де-факто для решения задач «Большой Аналитики» HPDA.

GFS ориентирована на обеспечение высокой производительности, масштабируемости, надежности и доступности, но при этом спроектирована для запуска на кластерах из массового компьютерного оборудования, то есть обладает высокой отказоустойчивостью и реализует автоматическое восстановление после отказов. Она нацелена на поддержку приложений, связанных с обработкой больших объемов данных, поэтому особое внимание уделено обеспечению высокой пропускной способности при доступе к данным в потоковом режиме, а не на низкой задержке (латентности). При этом система ориентирована на хранение и обработку файлов больших размеров (гигабайты и терабайты).

Первые прикладные проекты аналитики Больших данных показали, что первичные «сырые» данные, получаемые от датчиков или иных систем генерации исходных данных, — не лучшее сырье для работы аналитических систем. Природа исходных данных привела к появлению информационных структур двух типов: корпоративное хранилище данных, в котором храняться структурированные данные, и Data Lake («Озеро данных»), в котором структурировать данные не требуется.

Несмотря на то, что термин «Data Lake» впервые прозвучал в 2011 г., лишь несколько лет назад на рынке появились решения корпоративного уровня, содержащие законченный стек продуктов с бесшовной интеграцией. С тех пор базовым элементом ИТ–инфраструктуры 2.0 становится хранилище данных (уже существующее), интегрированное с вновь создаваемым «озером» Data Lake. В этой связи нельзя не упомянуть о задаче управления данными (Data Governance) в проектах, включающих создание Data Lake. Без ее решения будет невозможна качественная реализация таких концепций, как Data as a Service, Analytics as a Service, Self Service BI, Data Science, которые требуют однозначности определения бизнес атрибутов.

Однако все эти элементы ИТ–инфраструктуры являются лишь подготовительными процедурами для главного действия — аналитических процедур. Великое их разнообразие потребовало ввести некоторую систематизацию. Сегодня принято выделять три типа аналитической обработки: традиционная бизнес–аналитика (Business Intelligence, BI), традиционная предиктивная (прогнозная) аналитика и новый вид аналитических операций — прескриптивная аналитика.

Data Lake — это технологическая платформа, которая обеспечивает, с одной стороны, горизонтальную интеграцию всех источников данных и всех потребителей аналитики, а, с другой стороны, — вертикальную группировку по типам данных и соответствующим технологиям обработки. Такой подход позволяет не только хранить данные в «сыром» виде, но и обеспечивать максимально гибкую их интерпретацию, имея в виду реальную возможность появления новых вариантов анализа, не известных на текущий момент.

Например, платформа для Интернета вещей Lumada компании Hitachi Vantara использует принципы предиктивной аналитики для оценки собственной работоспособности, например, для более эффективного использования ресурсов, контроля производительности. Иными словами, позволяет развивать систему практически в режиме реального времени в том направлении, которое обеспечит максимальную производительность и минимальные риски отказов в работе конкретного приложения. Эти же программные механизмы помогают ускорить развертывание прикладных систем с учетом гибкой настройки под специфику задач клиента. То, на что раньше уходили месяцы и годы (проектирование системы, разработка модулей, внедрение, исправление ошибок) теперь решается в течение нескольких дней.

Использование автомобилей, оборудованных специальными средствами сбора информации о качестве дорожного полотна, позволяет накапливать огромные массивы точных данных о состоянии дорог и сигнализировать о необходимости их ремонта — это тоже предиктивная аналитика.

А вот получение данных для принятия наиболее обоснованного решения о выборе места и способа увеличения пропускной способности дорог на основе аналитических данных о техническом состоянии дорог и их загруженности — это прескриптивная аналитика. Образно говоря, результаты прескриптивной аналитики формируются как сочетание результатов предиктивного анализа нескольких бизнес–систем.

Хрупкость бытия в прозрачном цифровом мире

Выступая в начале декабря на IV Всемирной конференции по управлению Интернетом, Евгений Касперский отметил, что в 2018 г. ожидается появление более 90 млн новых вирусов. Для сравнения — 20 лет назад в мире было обнаружено всего 500 вирусов. По оценке аналитиков Сбербанка РФ, сделанной в прошлом году, количество киберпреступлений в России за год может вырасти в четыре раза. При этом общие потери от них превысят 2 трлн руб.

Трудно не согласиться с такими прогнозами, наблюдая рост градуса информационных войн, вот–вот грозящих перерасти в реальные кибервойны, которые захватят офлайн. Наблюдаемые процессы проникновения технологий обработки данных во все сферы человеческой жизни ведут к принципиальному пересмотру подходов к защите данных.

Эксперты даже говорят о кризисе всей традиционной системы информационной безопасности, которая все хуже справляется со своими задачами. Основная причина — в растущих скоростях протекания бизнес-процессов. Причем, эти процессы протекают в нечетких границах динамически меняющегося сетевого периметра, где неожиданно могут возникать мобильные устройства сотрудников или их домашние компьютеры. Проблема уже не только в наличии Shadow IT (соответствующую статью можно прочитать в №3-4, 2017 г., посвященном практической безопасности), то есть неучтенных ИТ–ресурсов, о существовании которых службе ИБ ничего не известно, а в том, что дать точное описание периметра становится практически невозможным.

Около 300 тыс. новых вирусов ежедневно регистрируется в мире, по данным Лаборатории Касперского

Порядка 60% бюджета ИБ предприятия будет выделяться на работу, связанную с быстрым обнаружением ИБ-инцидентов и реагированием на них, по сравнению с менее чем 30% в 2016 году, предсказывают аналитики Gartner

120 млрд долл. потратят к началу 2018 г. на борьбу с интернет–преступлениями в мире. По оценке BCG, рынок безопасности киберфизических систем к 2020 г. достигнет 389 млрд долл., а к 2035 г. — 2,1 трлн долл., то есть будет демонстрировать рост на уровне примерно 15% год.

До 2022 г. половина всех средств, выделяемых на обеспечение безопасности в IoT-сфере, будет уходить на устранение последствий киберинцидентов, а не на защитные меры.

Перспективный подход к созданию корпоративных систем информационной безопасности нового поколения лежит в русле общих принципов умной предиктивной и прескриптивной аналитики. Анализ на основе ML будет получать все большее распространение в ближайшие годы и поможет сформировать базовые элементы систем информационной безопасности различного назначения в составе ИТ–инфраструктуры 2.0. Кратко опишем далее их ключевые особенности.

Методы машинного обучения открывают путь к решению, пожалуй, главной проблемы различных ИБ–детекторов (IDS/IPS, WAF, DAM, Integrity Control, NetFlow анализаторы и т. д.) — большое количество ложных срабатываний. Эта задача может быть решена с помощью непрерывного настраивания политик средств защиты под конкретную ИТ-инфраструктуру. Однако очевидно, вручную справиться с этой задачей невозможно из-за ее высокой трудоемкости и сложности.

Для защиты от таргетированных атак (APT), использующих, помимо уязвимостей нулевого дня, разнообразные приемы социальной инженерии, методы на базе ML видятся наиболее удачными решениями этой непростой и крайне актуальной задачи. Можно даже утверждать, что сам классический подход к построению систем защиты, который базируется на строгой формальной модели известных угроз ИБ, в условиях нарастающих таргетированых атак трещит по швам. Он требует перехода к более гибким механизмам, способным к адаптации к неизвестным опасностям.

Механизмы машинного обучения отлично подходят для решения широкого круга задач, которые можно объединить под зонтичным термином «антифрод». Например, универсальное антифрод–решение Jet Detective использует обобщенные понятия объектов, признаков, поведения. Это обеспечивает большую гибкость в настройке, как на различные сферы применения, так и на конкретные методы анализа и логику принятия решений.

Это означает принципиально новый уровень скорости и точности выявления фрода с минимальными показателями ложных срабатываний. Можно достичь агрегирования данных сотен тысяч операций практически в масштабе реального времени из множества источников: от сетевых каналов до корпоративных бизнес–систем. Фактически речь идет об охвате всевозможных сведений, которые могут иметь отношение к происходящему, и мгновенной автоматической обработке всей этой информации. Такой всесторонний анализ всей полноты данных вряд ли достижим в реальной жизни антифрод-офицеров без соответствующего «умного» цифрового ИТ–решения.

Системы предотвращения утечек (Data Leak Prevention, DLP), по своей природе связанные с анализом передаваемых данных и действий пользователей, за счет применения методов ML переходят на принципиально новый уровень работы с контентной информацией. Все DLP работают в первую очередь с содержимым, самые «продвинутые» модели анализируют метаданные. В частности, у них исчезает зависимость от метаданных документов, поскольку работа идет непосредственно с их содержимым. В целом, ML «лечит» давнюю головную боли DLP–систем — контроль изменений в документах. Плюс к этому в сфере внимания DLP–системы на основе ML окажутся неформализованные данные, которые в традиционных системах, основанных на шаблонах, анализировать проблематично.

Технологии машинного обучения открывают новые варианты использования старого доброго метода детектирования злоумышленников, известного как «приманка» Honeypot (подробное описание этого подхода читайте в №3–4, 2017 г., посвященном практической безопасности). Инструменты ML обеспечивают высокую степень автоматизированности и гибкости процесса детектирования подозрительных событий при значительном сокращении сложности и трудоемкости необходимых действий.

Так, возможность имитировать любые корпоративные ресурсы в составе Honeypot позволяет создать такую «приманку», которая минимальным образом зависит от изменений реальной ИТ–инфраструктуры. Она практически не связана с реальной защищаемой инфраструктурой и при этом остается максимально актуальной. Образно говоря, грамотно внедренный Honeypot решает задачу не защиты активов, а противодействия активности нарушителя, отвлекая его внимание от реально ценных ресурсов на «пустышку».

С такой «приманкой» практически исчезает проблема ложных срабатываний, ведь легитимные работники никогда не будут предпринимать в отношении сенсоров Honeypot каких–либо действий: осуществлять удаленных вход, сканировать порты, обращаться к доступным сервисам и т. д. Следовательно, любая манипуляция с сенсорами с высокой долей можно считать инцидентом ИБ, требующим немедленного реагирования. При этом Honeypot — это пассивное средство защиты: оно не увеличивает нагрузку на ИТ–инфраструктуру и, тем более, не способно ухудшить производительность рабочих бизнес–систем, поскольку «приманка» с ними не связана.

Бесшовность — признак прозрачного мира

Cовременные понятия об архитектуре корпоративной ИТ–инфраструктуры постепенно меняют наши сегодняшние представления о локальном и глобальном. Где находится рабочее место сотрудника, если он редактирует текстовый документ на локальном ПК, затем ведет его обсуждение через облачный сервис, по итогам создает таблицу Excel через приложение Microsoft Office Suite, которое работает в корпоративном ЦОДе на терминальном сервере, а потом передает сведения в центральны офис, расположенный на другом конце страны?

Ключевой элемент ИТ–инфраструктуры 2.0 — это уже не локальное рабочее место сотрудника, а доступность и производительность нужных ему приложений и данных. Они должны работать со скоростью мысли человека, чтобы помогать человеку думать! Это достигается за счет бесшовного, то есть абсолютно незаметного для пользователя взаимодействия всех архитектурных элементов корпоративной ИТ–инфраструктуры. С этой целью работают системы мониторинга ресурсов, которые делают абсолютно прозрачной и понятной для администратора всю картину корпоративной информационной системы во всем ее географическом многообразии и динамичности. Бесперебойное предоставление ИТ–сервисов контролируется умными программными системами, которые держат в «голове» немыслимо громадный набор сложных и гибких SLA.

Постепенная интеллектуализация управления на инфраструктурном уровне приведет к трансформации рабочих задач сотрудников ИТ–отдела. Согласно прогнозу аналитиков Gartner, к 2021 г. в обязанности 40% ИТ-сотрудников компаний будут входить функции, большей частью связанные с бизнес-задачами, а не технологиями. Традиционным «айтишникам» следует готовиться к тому, что их сегодняшние знания и навыки могут оказаться устаревшими в ближайшие годы. В 2025 году вместо навыков виртуозного администрирования ИТ–систем массово востребованным станет умение извлечь из имеющихся данных новую ценность для бизнеса.

Подписаться

Подписаться Читать в телеграм

Читать в телеграм